Como instalar o Hadoop?

Índice

- Como instalar o Hadoop?

- Como usar Hadoop?

- Quem executa as tarefas no Hadoop 10?

- Quais os 3 modos de configuração permitidos pelo Hadoop?

- Como o HDFS permite o armazenamento de grandes massas de dados?

- Quais são os principais módulos do Apache Hadoop?

- Para que serve o Apache Hadoop?

- O que é Hadoop Big Data?

- Para que serve o Hadoop?

- Como o HDFS permite o acesso rápido a estes dados?

- Qual o arquivo que você precisa editar para configurar Hadoop?

- Qual o sistema operacional da Hadoop?

- Como criar uma conta de usuário para Hadoop?

Como instalar o Hadoop?

Instalação e Configuração do Hadoop (single-node) Edite o ficheiro hadoop-env.sh para definir a variável de ambiente JAVA_HOME. Clicar em guardar. Guardar o ficheiro. Concluímos assim ainstalação e configuração do Hadoop em Single-Node.

Como usar Hadoop?

Para funcionar, uma aplicação Hadoop exige no mínimo a utilização das ferramentas da camada de armazenamento (HDFS) e processamento MapReduce. As demais camadas podem ser adicionadas conforme a necessidade. A seguir, cada componente é explicado em sua essência.

Quem executa as tarefas no Hadoop 10?

No ambiente de execução o sistema Hadoop utiliza o modelo mestre-escravo para executar as tarefas.

Quais os 3 modos de configuração permitidos pelo Hadoop?

O Hadoop possui 3 modos de operação: Local (Standalone) Pseudo-Distributed Fully-Distributed Modos de Operação Neste apresentação será demonstrada a configuração e execução de um job no modo Pseudo-Distributed, também chamado Single-Node Cluster, no qual cada Hadoop daemon é rodado em um processo java separado.

Como o HDFS permite o armazenamento de grandes massas de dados?

O HDFS é responsável pelo armazenamento distribuído e pela clusterização de computadores que suportarão a guarda dos dados, utilizando grandes blocos de memória. Esse sistema gerencia o disco das máquinas que formam o cluster, além de servir para a leitura e a gravação dos dados.

Quais são os principais módulos do Apache Hadoop?

Componentes do Apache Hadoop O framework do Hadoop é composto por dois módulos principais: o módulo de armazenamento e o de processamento.

Para que serve o Apache Hadoop?

Apache Hadoop, é o principal framework utilizado no processamento e armazenamento de grandes conjuntos de dados – Big Data. ... Uma plataforma capaz de armazenar e processar, em larga escala, grandes conjuntos de dados – Big Data, que funciona em clusters de hardware de baixo custo, tolerante a falhas.

O que é Hadoop Big Data?

O Hadoop é uma estrutura de código aberto que serve para lidar com todos os componentes do armazenamento e do processamento de quantidades enormes de dados. ... Por ter um baixo custo inicial e permitir a análise de dados sob demanda, ele é uma forma atraente de processar o Big Data.

Para que serve o Hadoop?

Hadoop é uma estrutura de software open-source para armazenar dados e executar aplicações em clusters de hardwares comuns. Ele fornece armazenamento massivo para qualquer tipo de dado, grande poder de processamento e a capacidade de lidar quase ilimitadamente com tarefas e trabalhos ocorrendo ao mesmo tempo.

Como o HDFS permite o acesso rápido a estes dados?

HDFS armazena grande quantidade de dados e permite um acesso mais fácil. Para armazenar dados tão grandes, os arquivos são armazenados em várias máquinas. Esses arquivos são armazenados de forma redundante para resgatar o sistema de possíveis perdas de dados em caso de falha.

Qual o arquivo que você precisa editar para configurar Hadoop?

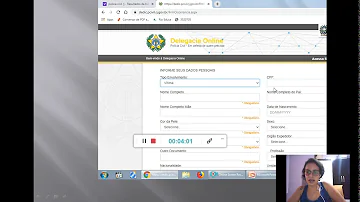

A seguir estão a lista de arquivos que você tenha que editar para configurar Hadoop. Core-site.xml O core-site.xml file contém informações como o número da porta usada para Hadoop exemplo, memória alocada para o sistema de arquivos, limite de memória para armazenar os dados, e o tamanho das ler/escrever buffers.

Qual o sistema operacional da Hadoop?

Hadoop é suportada pela plataforma GNU/Linux e seus sabores. Portanto, temos de instalar o sistema operacional Linux para configurar Hadoop meio ambiente. No caso de você ter um sistema operacional diferente de Linux, você pode instalar o Virtualbox software e ter Linux dentro do Virtualbox.

Como criar uma conta de usuário para Hadoop?

No início, é recomendável criar um usuário separado para Hadoop para isolar Hadoop file system do sistema de arquivos Unix. Siga os passos abaixo para criar uma conta de usuário. Abra o root usando o comando "su". Criar uma conta de usuário da conta root usando o comando "comandos useradd usuário".